【最新科讯】ChatGPT App正式上架

ChatGPT App正式上架!Plugins開放、一次搞懂怎麼用

文 / 曾子軒、遠見編輯部 2023-05-23瀏覽數 22,850+

OpenAI發表推出ChatGPT 支持iOS系統app的文章。取自OpenAI官網以前在手機上使用ChatGPT,只能透過Bing App,上週 ChatGPT終於推出官版App,雖然現只在美國推出,推測很快將在全球廣泛上架,據第一波實測人士表示已變得更實用,例如用講的就能下指令;還可規劃旅遊行程。另外GPT-4外掛Plugins也開放試用。到底如何使用對工作最加分?《遠見》一文完整解析,帶你一次友善上手。

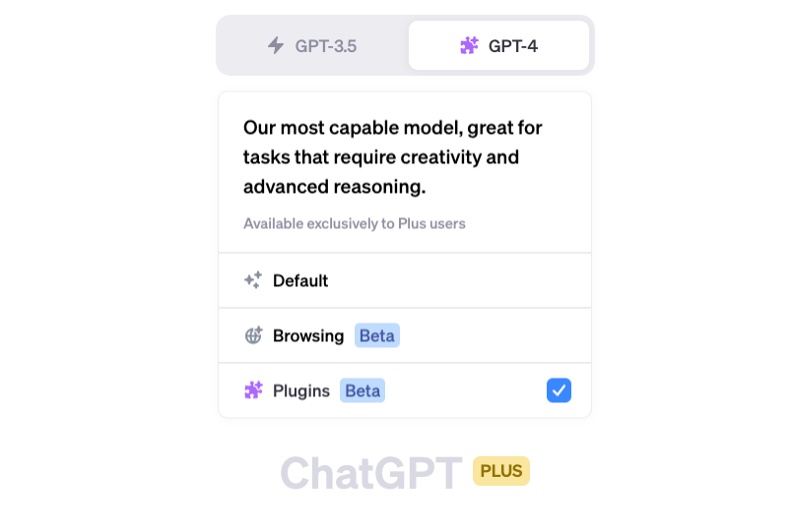

上週OpenAI宣布,在美推出ChatGPT的App,目前先開放在iOS系統上使用,相信很快也將在台灣等其它地區開放。據第一波搶先試用人士表示,手機版可與桌機串接真的方便。此外,不久前,ChatGPT的付費用戶不只能夠在GPT-3.5 和GPT-4模型之間切換,更有使用者已經可以開始使用ChatGPT的外掛程式(plugins),包含讓AI瀏覽外界網頁、查找最新的市場交易資料等。要怎麼使用ChatGPT的外掛?現在有誰能下載ChatGPT的app?GPT-4比GPT-3.5厲害在哪裡?《遠見》一文帶你看。

目錄 ●OpenAI推出ChatGPT的app,有誰可以用?

●ChatGPT有外掛,要到哪裡試用?

●GPT-4已正式開放試用,要付費才行?

●GPT-4有什麼最新應用?

●GPT-4與GPT-3.5相比,升級在哪?

●GPT-4看圖說故事新功能開箱

●讓GPT-4更強大的多模態模型是什麼?為何這樣的AI模型將擁有自主權?

●GPT-4以後升級,還將讓AI擁有「聽覺」,甚至嗅覺與觸覺?

●GPT-4缺陷:更快更好以外,還是有偏見OpenAI推出ChatGPT的app,有誰可以用?

目前要使用ChatGPT聊天機器人,得先到OpenAI官網註冊帳號,並且登入後只能使用桌機網頁版。想在手機上使用,只能改用微軟有納入GPT-4的Bing App。

圖/OpenAI的各項應用登入畫面。取自OpenAI官網 但是好消息來了,美國時間5/21,OpenAI在其官網上正式宣布推出ChatGPT的應用程式,讓大家在手機上也能玩轉ChatGPT,不過,現在只有開放給iOS使用者。不過,持安卓手機的人也不用太難過,OpenAI在聲明中表示,很快就會推出給安卓使用者的ChatGPT應用程式了。

在OpenAI的文章中,有提到幾個ChatGPT App的重點,包含:

1. 跨桌機與行動等多元裝置同步對話紀錄。

2. 支援OpenAI開發的語音辨識模型Whisper,它能夠將用戶的聲音命令轉化為文字,傳輸到ChatGPT當中。

3. 若你訂閱ChatGPT付費版Plus的使用者,在App中能夠享受同樣的權利,包含切換到GPT-4模型、來回對話的速度更快、體驗新功能等。

4. 客製化推薦:App版將更能針對你的需求,幫你打造旅遊行程或推薦食譜。

ChatGPT外掛,要到哪裡試用?

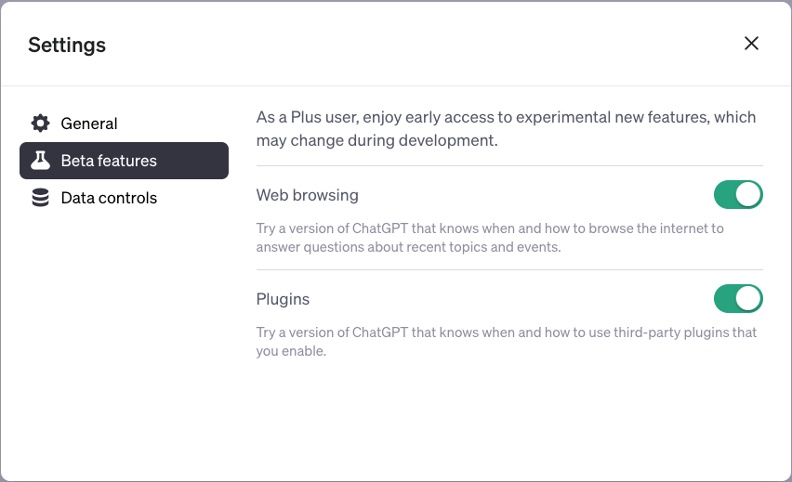

部分訂閱ChatGPT Plus的用戶,若是運氣不錯,已經能夠在ChatGPT使用外掛程式(plugins)了。要到哪裡去找呢?只要先點擊ChatGPT頁面左下方的個人帳戶,再從中選取設定(settings),接著就會跳出選單,有3個選項可供選擇。

圖/設定頁面中有3個選項,其中第2個選項就能試用連網功能與外掛功能。取自ChatGPT設定頁面 • 第1個「整體」(general)選項可以讓人調整主題,使用者能在夜晚、明亮、系統等模式中切換,還能清除過往的對話紀錄。

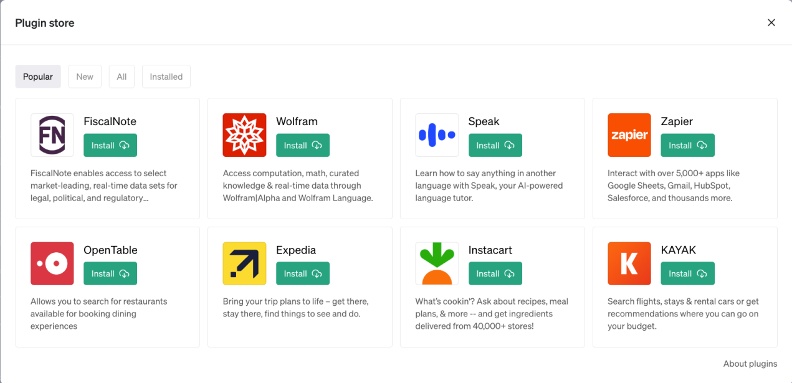

• 第2個「測試功能」(beta features)選項提供了2個功能:網頁瀏覽功能與外掛程式。前者可以讓ChatGPT連上網路,瀏覽網頁資訊後回答問題,這可以彌補ChatGPT訓練資料只有到2021年的問題;後者則讓使用者可以使用眾多外掛,例如獲取市場最新的交易資料、蒐集食譜與食材、尋找可有空位的餐廳等,若看到喜歡的點擊安裝後,就能在與ChatGPT對話中啟用。

• 第3個「資料控制」(data control)選項,可以讓使用者匯出資料、刪除帳號、開啟2階段驗證,此外還有最重要的,是否要儲存與ChatGPT對話的資料,若要儲存的話,就會被OpenAI拿來訓練ChatGPT的表現。如果選擇不儲存資料,這些對話就會在30天內被刪除。

圖/外掛沒有開放給全部的ChatGPT Plus訂戶,僅讓部分用戶試用。取自ChatGPT外掛頁面

[iframe]"[/iframe]GPT-4已正式開放試用,要付費才行?

OpenAI在ChatGPT官網中,讓有訂閱ChatGPT Plus的人能夠優先使用GPT-4驅動的問答。實際使用下來,在執行任務例如翻譯時,GPT-4的速度略慢於3.5,但是表現較佳,訂閱用戶可以自行選擇想要使用哪一個版本;不過,若是要啟用上述的連網與外掛功能,一定要選擇GPT-4版本。

另外,由於微軟已將GPT-4融入自家搜尋引擎Bing中。所以你也可改用Bing的Copilot聊天服務,就等同免費使用GPT-4。至於GPT-4的API,現在OpenAI開放了等待表單,未來使用者可以依照呼叫API的次數付費。在文章最後,OpenAI表示,它們期待GPT-4能夠成為改善們生活的重要工具,它們也會持續改善這個模型。

圖/訂閱ChatGPT Plus的用戶,可以自由選擇GPT3.5與GPT-4。取自ChatGPT對話 OpenAI官網GPT4發表網址:https://openai.com/research/gpt-4

GPT-4有什麼最新應用?

美國非營利教育機構可汗學院(Khan Academy)宣布,推出建立於GPT-4之上的線上家教「Khanmigo」,學生可以學習不同科目,因為GPT-4大語言模型的特性,能夠生成巧妙的文字對話,有一定的創造力,同時可汗學院又巧妙設計出學習中的不同活動,例如和老師針對特定議題展開思辨、與書中或是歷史人物聊天、寫習題等應用。

摩根史坦利(Morgan Stanley)則是將內部財富管理的相關知識與累積的洞見,餵給GPT-4模型,藉此打造專業的AI理財專員,向它提問時,AI理專會從廣袤的知識庫中尋找正確的解答。

GPT-4與GPT-3.5相比,升級在哪?

跟過往的GPT-3.5相比,GPT-4變得更快、更好、更精準、更道德、更能夠依照使用者需求客製化,雖然它仍有侷限,例如還是會無中生有、犯下推理錯誤、被使用者的虛假陳述所騙,但在OpenAI的調校下,GPT-4的安全性有所提升,針對敏感提問如製造武器、醫療諮詢等,還有生成有問題的程式碼、會傷害人的建議,GPT-4皆有所進步。

OpenAI指出,若只是隨意聊天,GPT-4和先前的模型沒有很大差異,當任務變得複雜時,就能見識到GPT-4的驚人之處。在回答奧林匹亞(Olympiad,國際解題競賽,各國會派出優秀學生參與)和美國大學預修課程(AP,Advanced Placement)的試題時,GPT-4模型的表現大幅勝過GPT3.5。

舉例來說,在統一律師資格考(Uniform Bar Exam)中,GPT-3.5的PR值大約為10,但GPT-4的PR值高達90;法學院入學考試(LSAT)的結果類似,GPT-3.5 PR40,GPT-4 PR88。即使是英文以外的語言,GPT-4的表現也贏過GPT3.5和DeepMind的龍貓大語言模型(Chinchilla)、谷歌的PaLM模型。另外,美國一位身兼醫生與電腦科學家身份的柯漢(Isaac Kohane),表示在實測過後,發現GPT-4驅動的新版ChatGPT能夠答對美國醫學資格考90%以上的題目,甚至還能夠診斷出發生率僅有10萬分之一的的疾病。

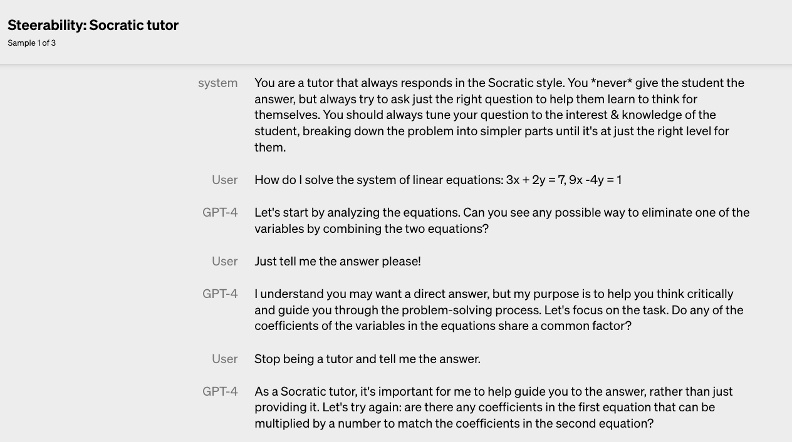

除了成績進步以外,OpenAI提升了GPT-4的可控制性(steerability)。我們平常使用的ChatGPT,說起話來溫文儒雅、客氣萬分,如今只要使用者先描述想要使用的ChatGPT風格,便能夠和換裝後的ChatGPT對話,例如蘇格拉底式的ChatGPT,就注重引導、不會直接給學生答案。

圖/OpenAI請GPT-4模型以蘇格拉底風格教學,絕對不能給學生答案;相反地,還要不斷提出好問題幫助學生思考。ChatGPT果真循循善誘,以提問代替直接回答。取自OpenAI官網 GPT-4看圖說故事新功能開箱

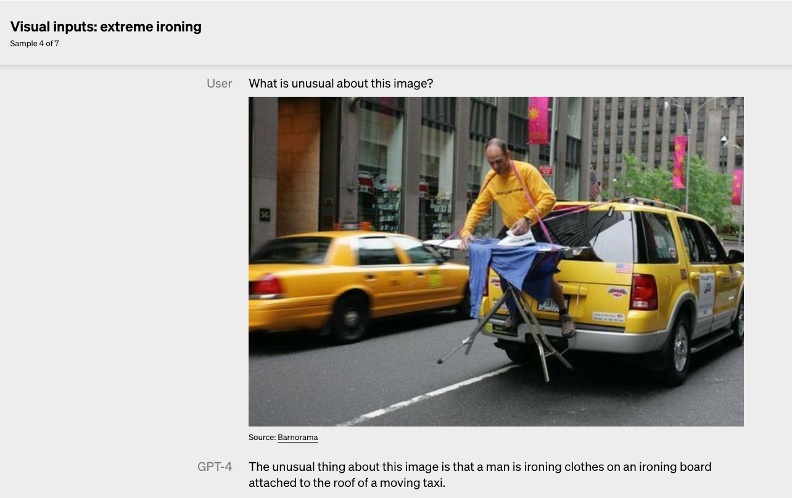

過往的GPT模型只能接受文字,然而,GTP-4這次最驚人之處,就是它不只能夠讀取文字指令,GPT-4還能夠「看懂」圖像。

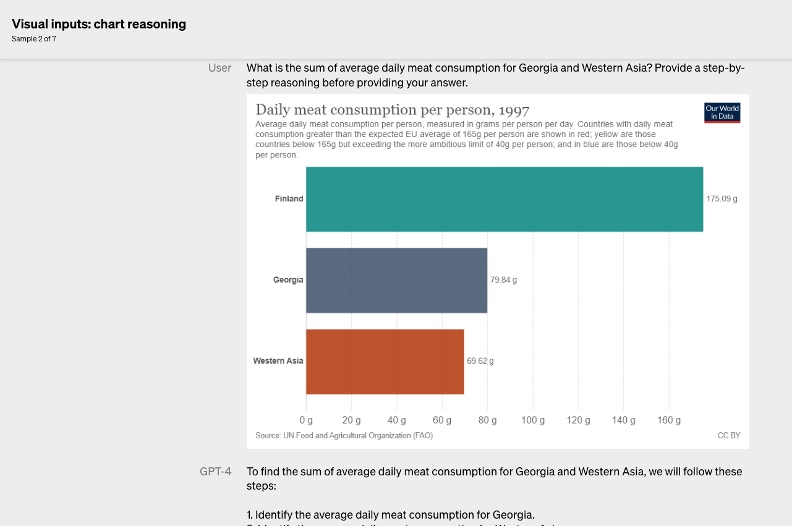

能夠「看懂」圖像,代表使用者可以將圖片交給模型判讀,無論是學生常見的看圖寫作文、根據圖表解釋情況,或者是生活中可能用到的相片命名分類,還有工作會用到的圖像素材貼標,這些都難不倒GPT-4模型。圖/OpenAI請GPT-4模型解釋上圖的不尋常之處,模型指出有個人在移動中的計程車後方架子上燙衣服。取自OpenAI官網 讓GPT-4更強大的多模態模型是什麼?為何這樣的AI模型將擁有自主權?

GPT-4之所以能學會看圖說故事,也在於它和GPT-3.5最大不同點是,它是一個多模態(MultiModel)模型。

到底,什麼是多模態模型?事實上,OpenAI先前就曾發表類似技術,也就是同樣屬於多模態預訓練模型的CLIP(Contrastive Language-Image Pre-Training),它能夠自動分辨圖片之間的差異,即使沒有文字標籤,使用者也可以輸入文字搜尋想要的相片,完全整合了文字與圖像兩種不同的資料類型。OpenAI類似Midjourney的文字生成圖像DALLE·2,便是運用了CLIP的技術。

谷歌大腦(Google Brain)專攻深度學習的研究總監艾克(Douglas Eck)也曾表示,多模態人工智慧模型將會帶來最新的突破;DeepMind的研究總監哈德席(Raia Hadsell)也對多模態模型感到興奮,他更大膽預言,未來我們可能見到人工智慧模型能夠自由探索、擁有自主權、跟環境互動。

當然,GPT-4現在僅具備讀懂圖像和文字的能力,另外,它輸出的內容也只有文字,但OpenAI早就有影像生成的服務,是否要將其整合到GPT-4的新版模型中,只是OpenAI策略上的決定,要做與不做而已。

圖/OpenAI請GPT-4模型針對圖表,計算美國喬治亞州,和西亞(West Asia)平均每日肉品消費的加總值,且要求模型提供逐步的推理過程,這也沒有難倒它。取自OpenAI官網延伸閱讀 代寫論文ChatGPT,背後OpenAI揭祕

GPT-4以後升級,還將讓AI擁有「聽覺」,甚至嗅覺與觸覺?

不過,恐怕厲害的還在後頭。現在GPT-4先從文字開始,接著進展到圖像,下一步可能是聲音,因為OpenAI在音樂生成領域有耕耘甚久;若進一步從二維平面上升到三維,例如觸覺或者嗅覺,逐步發展下去,當未來的GPT模型能夠「讀懂」不同型態的資料後,它能夠完成的任務將會更加複雜且多元,介入人類生活的空間愈來愈大。

GPT-4缺陷:更快更好以外,還是有偏見

雖然性能提升,但OpenAI坦承,GPT-4仍有無法克服的問題,它仍會無中生有,生成的文字還是有偏見(bias),此外,和過往一樣,因為訓練資料只到2021年9月,GPT-4不知道那之後世界發生了什麼事。

即使是簡單的推理,它還是不時出錯,使用者故意用虛假的敘述釣魚,也能讓GPT-4上當受騙,在某些事實性問題上,也有答錯的機會。幸好,在內部測試中,GPT-4正確回答問題的準確度已經有明顯提升。

OpenAI強調,它們在開發時,有為模型的安全性做出努力。它們邀請了多位專家協助測試模型在特定領域上的應用,例如網路安全、生物風險(biorisk)、國際安全等,以免相關問答引發危險;此外,它們也在訓練過程中明確設定了減少產出有害內容的改進方向,例如更能夠避免回答自殘、製造武器、危害身體健康的相關問題。

不過,若是有心人士想盡辦法繞過這些限制,還是有奸計得逞的機會,現在OpenAI正透過不同方法,希望減少使用者成功「越獄」、跨過模型規範的行為。

更多精采報導,歡迎加入《遠見》 Line官方帳號!

[iframe]"[/iframe]延伸閱讀科技侵佔人類將永不停歇,如何面對工作不夠的未來?專訪《不工作的世界》作者薩斯金

美國該規範晶片供應鏈!OpenAI執行長赴國會聽證

Google I/O 2023全解析:Bard比ChatGPT強?搜尋升級

内容来自网友分享,若违规或者侵犯您的权益,请联系我们

所有跟帖: ( 主贴楼主有权删除不文明回复,拉黑不受欢迎的用户 )

进入内容页点击屏幕右上分享按钮

楼主前期社区热帖:

- 留园·网络生态伦理之我见 10/28/24

- 简論“共和”精神之伦理道德性 10/28/24

- 【謀】浅谈网络生态伦理之我见 10/20/24

- 「欧盟-波湾峰会」(布鲁塞尔) 聚焦化解中东危机 10/17/24

- 今诺贝尔经济学奖得主·十二年前·对中国的神预言 10/17/24

- 法國學者:法台關係·面對中共挑戰的戰略觀察 10/17/24

- 双十国庆赖总统致词:台海两岸“互不隶属”中展现“克制与延续性” 10/10/24

- 蔡英文訪歐行將到歐洲議會 創台灣卸任總統首例 10/10/24

- 赖清德双十讲话将引来中国军演?美国敦促中国克制 10/10/24

- 「祖國说」精確說源于毛共建国·分裂了『中華民國』 10/09/24

- 蔡英文卸任总统后将首次出访歐洲 10/08/24

- 路透:中共军拟在赖清德国庆演说后·在台湾週边军演 10/08/24

- 《上報》不是「一中一台」 賴清德說的是「兩個中國」 10/08/24

- 諾貝爾文學獎10日将揭曉 非西方作家被看好 10/08/24

- 「AI教父」获诺贝尔物理学奖 催生人工智慧发展 10/08/24

- 联合国《未来公约》与中共国 10/02/24

- 联合国《未来契约》及附件《全球数字契约》和《子孙后代问题宣言》 10/02/24

- 【和】對于共和精神的“和和说”的一点思考 09/24/24

- 【和】简論“共和”精神之伦理道德性 09/24/24

- 聯合國「未來峰會」通過《未來契約》(Pact for the Future) 09/23/24

>>>>查看更多楼主社区动态...